世界头条公司(世界头条干嘛的)

新智元原创

来源:thenextplatform.com

作者:胡祥杰

【新智元导读】 昨日,NASA 75岁高龄的前主管Goldin向外界透露了花费十年时间经营的初创企业,瞄准深度学习芯片市场,剑指谷歌、Intel。Goldin介绍的这款据称基于稀疏矩阵的深度学习芯片,在能耗和延迟率方面有良好表现。这款芯片真的有那么好吗?会对目前的芯片市场产生什么样的影响?Goldin低调运营了10年的KnuEdge究竟是一家什么公司?不妨来探个究竟。

根据国外多家媒体报道,NASA前高管Daniel Goldin当地时间6月6日向外界透露,自己默默耕耘了十年的芯片公司KnuEdge已经在筹备第二款深度学习芯片,很快会推向市场。

KnuEdge是一家以开发神经网络芯片为目标的公司,Goldin在接受VentureBeat采访时说,公司已经获得2000万美元营收,目前获得的投资超过1亿美元。KnuEdge正在与超大规模计算公司,以及航天、银行、医疗、宾馆和保险行业的财富500强公司积极接洽。

市场研究公司Tirias Research首席分析师鲍罗·泰奇(Paul Teich)在一份声明中说,“KnuEdge脱离‘隐身模式’,目的是利用其全新语音和机器学习技术,解决物联网、基于云计算的机器学习和模式识别领域的关键难题。”

究竟是什么样的芯片,能让NASA前高管隐身10年,并喊出领跑谷歌、intel的口号?是噱头还是实力?

10年磨一剑,颠覆冯·诺依曼架构

Goldin称,KnuEdge芯片基于“稀疏矩阵”。第一个芯片有256核,程序员可给每个核做不同算法的编程,并可使所有核同时运行。

正如 对The Next Platform所说的那样,他所关注的未来应用的范围,已经超越了冯·诺依曼(Von Neumann)架构,超越了稠密矩阵的方法,立足于解决现实问题。他的关注点转移到了超级计算应用中一个已经确立的领域,即基于稀疏矩阵的问题,以及通过更加高效的存储模型和轻型的内核达到的、拥有更低延迟率的计算所需要的技术。

经过了长达10年的发展,这一想法带来的结果是,2015年年末,Knupath向第一位客户交付了首款芯片。Knupath的第二代产品“Hermosa”,将会在2017年下半年推出,这是一款完全内部设计和组装的定制DSP,以及新的“Lambda”模块,既可以连接多个Hermosa芯片,也有潜力被多个系统的机架(Racks)采用。

在一个由以稀疏矩阵为基础的计算主导的未来,这会是一个解决的办法,正如Goldin预测的的那样,这种计算方式在未来的机器学习应用中将会越来越多。

这样的系统是可扩展的,可容纳到512,000块芯片,每一个芯片有256t的DSP内核(t 指的是“tiny”,配一个单一的ARM管理内核)。

延迟率是比较有说服力的,机架到机架(rack to rack)的延迟为400纳秒(十亿分之一秒)(与当下最快的Ethernet一样快),所有的这些芯片都有高效且特别处理稀疏矩阵的能力。迄今为止,已经有一些研究开始把在深度学习中使用的稀疏矩阵驱动的计算向专用型转化,但是,一个平台上来做这件事的,还没有。确实,这意味着在工作流上完全的转换。Goldin在这方面下了很大的赌注,他认为这种转换是值得的。

第一代的产品基于PCIe,有多个处理器,可以在多个Hermosa处理器上建立。Fabric是异构的,能容纳多种类型的处理器(X86,GPUs,FPGAs)。这家公司的计划是,到2017年推出的第二代产品,要支持所有的这些处理器,同时也是多程序的和多数据的。这意味着从理论上来说,256种不同的算法可以在Hermosa中的单个内核中运行。Goldin说,在未来的应用,比如信号处理和机器学习,以及一些被他们列为目标的金融服务中,这种芯片的重要性会变得越来越明显。

在这,Lamba Fabric 是最有意思的。它包括在主板上的多个小型处理器或者一个设备中的单个处理器上,一直到521000块芯片的组合。它基于一个分布式内存模型,在那儿,内核之间会共享内存,并且,被分享的内存也在系统中进行分布,这就是你得以看到DMA控制器(在系统中移动数据)的原因。

在一个综合的存储器内,机器的带宽能达到3.7兆兆字节(terabytes)每秒。而在可扩展的边界,每一个小的“cluster”都拥有DSP中共享的内存,所以记忆带宽数量能和芯片的数量同比例增长(为系统增加更多意义,增加更多内存和内存带宽)。

每一个Knupath处理器内核都有针对通信、同步以及解决稀疏矩阵难题(处理能力的分散或聚集)的内部指令,还拥有可编程的DMA引擎,以支持256t DSP内核的内存基础工作。从可扩展性上看,除了可以建立512,000个排列外,系统还能提供最高3.702GB每秒的内存带宽。最大能耗峰值达34瓦特每芯片。跟FFT和公司在运行的其他Benchmarks比起来,这提供了一个稳定的”watt-to-watt“的性能(但是在2017年正式发布前,将不会有更多的消息)。

此前,我们已经讨论过关于在深度学习中使用GPUs和相关的工作,以及FPGA的潜力,当下,对谷歌和其他公司的(TPU是最好的例子)尝试也进行了分析。那么问题来了,为什么要使用DSP?如果说接下来,这一处理器 将会得到广泛地采用,其中还包括即将推出的Tianhe-2超级计算机,但是,除了信号处理外,还没有别的应用。

Goldin说,他们关注的主要还是处理,但是把这些能力转换到一个节能的稀疏矩阵的功能中,其实并不是首例。

虽然他没有分析Benchmarks,但他提到AlexNet 和GoogleNet 的性能是2X到6X之间。当然,没有细节我们也不方便作过多评论。Goldin确实提到了其他两个可能会是做出这种选择的原因。 第一是成本,第二个是可编程性。DSP并不贵(当然,只是相对的),但是,Knupath没有从德州仪器公司(Texas Instruments )或者别的地方为自己的技术寻找产品,而是自己设计。

从编程的角度看,Goldin说他希望获得DSP的灵活性,尤其是在信号处理方面的用户,在这领域中,FPGA的编程是昂贵且费时的。

“我们希望在内存附近进行即时的处理——一个推模式(a push model)。你不需要Cache,你不也需要做提取(Fetch)。我们设计这个并不仅仅为了处理,我们还要在沟通和内存处理中做平衡。它是一个沟通者,正中的地方有一个路由器(router )”,Goldin解释说。不过,他们能在2015年拿下第一款芯片的出售合同,却是因为eDRAM,它把每一个tDSP都紧靠在内存旁,以进行即时的联系。虽然下一款芯片不能再使用这一技术,但是他们发现了一个合适的的工作区。虽然他们也不能就此提供更多的细节。

基于PCIe的加速器版本的编程模式很像CUDA/OpenCL,尤其是在主系统和芯片之间进行沟通时,系统内的芯片之间的沟通有一个更像MPI的模式。然而,跟使用GPU不一样,这一芯片能在不同的cards之间进行沟通,并允许他们在不通过PCIe或者CPU的情况下进行交流。Goldin说,他的团队正在与Larry Smarr博士合作,准备推出一个未来大赛,关注稀疏矩阵操作的工作,以推动平台上软件的发展。

图:Goldin说,公司正在寻找合作伙伴,包括FPGA和GPU市场。他还说,未来ARM的重要性将会得到稳固增长。

“需要指出的是,从数据在Fabric中的流动来看,这有什么不一样”,Goldin解释说,“我们通过架构来发送数据,而不是从内存和提取数据和应用,在这一个数据的集合中,不仅是数据会被计算,编程的每一步也会被计算,数据的下一个目的地也会被计算出来。”最终,随着其他的数据按照架构设定的目标流动,这完全翻转了冯·诺伊曼架构。

说得更清楚一些,Hermosa处理器依然能够处理稠密矩阵,即使这并不是它的目标。“谈到机器学习,我们依然处于蛮荒之中”,Goldin说,“但是随着我们开发出许多不同的算法,平台是必须的,而这一切依靠的新趋势就是稀疏矩阵。”

虽然仍处于早期,但是确实有许多探索在寻找用稀疏矩阵来促进深度学习训练在性能、效率和编程上获得优势的可能性。然而,要下结论还为时尚早,并且,向这种模型的转化,对潜在的回报也有高的要求。

所以,我们已经把关于这一架构的一切都展现了出来,对于未来深度学习中分散和聚集/稀疏矩阵中的深度研究还非常少。虽然如此, 一种基于DSP的方法就能获得1亿美元的投资,已经相当有启发性。我们必须思考,有人看到了这个机遇,特别是考虑到在过去几年中,我们已经看到许多深度学习芯片的崛起。

另一个角度是,许多新的客户尤为钟爱单一处理器,并且,与深度学习沾边是获得更大吸引力的保证,虽然深度学习还是在发展之中,并且能发展到什么程度谁也不能保证。

芯片之外,语音登场

KnuEdge芯片是更大平台的一部分。戈尔丁说,KnuEdge还将发布KnuVerse——军用级语音识别和认证技术,它将使语音技术用于下一代计算系统。

尽管过去5年语音技术市场在Siri、Cortana、Google Home和Echo等语音助手推动下呈现爆炸性增长态势。但是,受安全和噪音问题影响,大多数商业性语音技术团队的愿景尚未实现。KnuVerse解决方案基于获得专利的语音识别技术,适用于噪音非常大的环境。安全的语音识别技术可以应用于银行、娱乐和宾馆行业。

KnuEdge表示,无论用何种语言,只要对着麦克风说上数个单词,计算机、移动应用和物联网设备就能对用户身份进行认证,这一过程不会受到环境噪音的影响。除KnuVerse外,KnuEdge还面向开发者发布了Knurld.io开发工具和一款基于云计算的语音识别和认证服务。通常情况下,把这一服务整合到应用中只需2小时。

深扒KnuEdge

Goldin于2005年在San Diego创办Intellisis,如今这个公司的网站已经不可访问,它的Wiki页面还在,它应该是改名为Knuedge了。这家公司注册在10350 Science Center Dr San Diego, CA 92121,它的网站是https://www.knuedge.com登陆后可以看见如下信息:

该公司旨在探索根本性的转变,并提供改变人机交互方式的下一代技术,从语音识别和认证到机器学习。该公司领先的技术进步主要在硬件大型数据中心和语音处理,拥有的绝大多数专利也都是与音频相关的。

Knupath是Knuedge刚刚成立的子公司,专门做芯片的,注册在6500 River Place Blvd Building 7, Suite #100 Austin, TX 78730。在公司的官方宣传中,我们可以看见相比新闻报道“颠覆冯诺依曼结构”这种炫酷的说法更为实际的描述:

KNUPATH是一家致力于开发下一代适应性强、进行大规模并行处理的技术。我们的专用处理器和独特的fabric能够解决一些当前世界上最复杂的问题。

Godlin 在接受 VentureBeat 的采访时表示,其公司已经盈利200万美元,并积极寻求合作机会,与世界500强企业构建超大规模计算架构。可以推断,这家公司一开始就专注于音频,考虑到 Godlin 的背景,这家公司应该能找到客户提供监听的解决方案。最近几年人工智能,尤其是智能语音火了,他们就准备进军民用市场,颠覆冯诺依曼构架只是推销芯片所用的宣传策略而已。

仔细看这个图,封装好的die上面,就只有8个tDSP,每个tDSP很可能就是一个ARM。32个芯片构成supercluster。所谓的256核是这么计算出来的。cluster和supercluster内部的互联采用LambdaFabric。

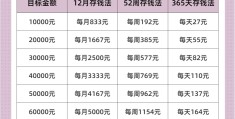

芯片内部的运算能力稀松平常,其最值得称道的LambdaFabric,400ns的rack-to-rack延迟。本机访问内存的延迟有个100ns多都很正常。常见的latency参见下表:

通过省去了PCIe、Ethernet等协议中所有的繁文缛节,直接往远端的核的片上SRAM里写(push)数据,这款芯片做到了这么小的latency。

因此, 这款芯片实际上并没有号称的那么强大。不过,相关报道里提到的这句话值得赞同:

人脑里面没有NUMA、UMA这种概念,存储和处理合一。未来超高性能神经网络计算中,控制数据的流动远比对数据的计算更重要、更复杂,这一任务必须精细、高效组织和控制。

「招聘」

全职记者、编译和活动运营

欢迎实习生

以及人工智能翻译社志愿者

详细信息请进入公众号点击「招聘」

或发邮件至 jobs@aiera.com.cn

新智元相关招聘信息请点击“阅读原文”